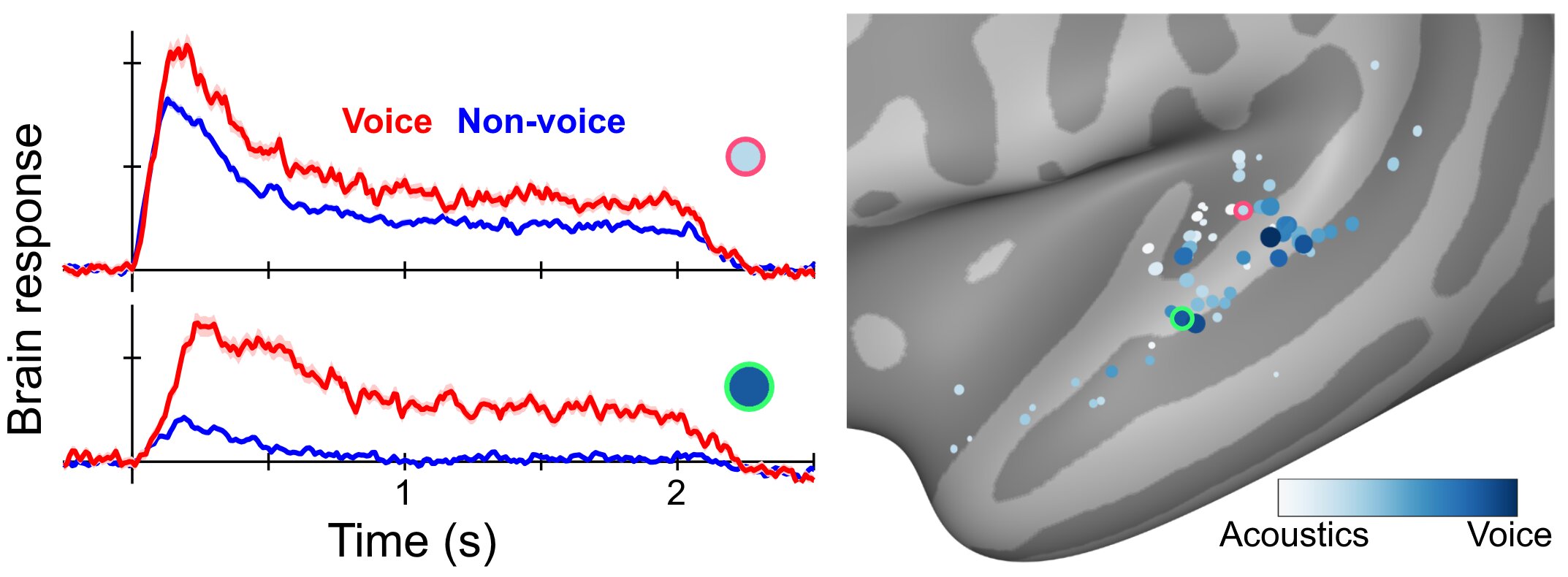

Distintas regiones de la corteza auditiva ubicadas en la circunvolución temporal superior y el surco temporal superior están especializadas en reconocer los sonidos de la voz (que se muestran en azul oscuro) y no responden a las señales acústicas que no son de voz. Crédito: Kyle Rupp y Taylor Abel

Partes específicas del cerebro reconocen señales complejas en los sonidos vocales humanos que no involucran el habla, como llorar, toser o jadear, encontraron investigadores de la Universidad de Pittsburgh.

En un artículo publicado hoy en PLOS Biología, los científicos demostraron que dos áreas de la corteza auditiva están especializadas para reconocer los sonidos de la voz humana que, a diferencia del habla, no tienen significado lingüístico. Más bien, nos ayudan a reaccionar a las señales de sonido que permiten a las personas identificar instantáneamente las características de la persona que está hablando, como el género, la edad aproximada, el estado de ánimo e incluso la altura, todo sin verlos.

«La percepción de la voz es similar a cómo los humanos reconocen diferentes rostros», dijo el autor principal Taylor Abel, MD, profesor asistente de cirugía neurológica en Pitt. «Las voces que no incluyen el habla, por ejemplo, el llanto, la tos, los gemidos o las exclamaciones de un bebé, nos permiten obtener mucha información sobre la persona que hace esas vocalizaciones en ausencia de otra información sobre la persona».

Los seres humanos vivimos en un mundo lleno de sonidos, donde los ruidos del entorno dan forma a nuestras interacciones diarias con nuestro entorno y otras personas. Y aunque el habla es uno de los aspectos únicos de la comunicación humana que no tiene análogos directos en el mundo animal, las personas no confían solo en el habla para transmitir información auditiva.

Los aspectos de la voz que no son del habla cumplen un papel vital en nuestra caja de herramientas de comunicación, ampliando la capacidad humana para expresarse de manera precisa y dinámica. Parte de esa expresión es subconsciente, y parte de ella puede ser modulada intencionalmente por el hablante para transmitir un amplio espectro de emociones, como felicidad, miedo o disgusto.

Los seres humanos nacen con la capacidad de reconocimiento de voz; de hecho, los bebés pueden reconocer la voz de su madre mientras aún están en el útero, pero esa capacidad es dinámica y continúa evolucionando a lo largo de la adolescencia.

Abel, que es un neurocirujano pediátrico en ejercicio que se especializa en epilepsia, tuvo una oportunidad única de observar cómo responde el cerebro humano a la voz.

Para identificar las regiones del cerebro que son responsables de generar convulsiones en algunas personas con epilepsia, los neurocirujanos pueden implantar electrodos temporales en el cerebro para registrar cuidadosamente sus señales eléctricas. Esta práctica permite a los médicos ubicar con precisión el sitio de la convulsión y, finalmente, extirpar esa parte del cerebro, sin afectar el tejido sano circundante.

Ocho pacientes con epilepsia aceptaron participar en un estudio en el que Abel y su equipo usaron los electrodos implantados para medir qué áreas de la corteza auditiva respondían cuando se presentaban a los pacientes sonidos de voz (gruñidos, aullidos, risas).

Usando una combinación de grabaciones cerebrales directas y modelos computacionales, los investigadores pudieron describir con un detalle sin precedentes cómo evoluciona la representación de la voz con el tiempo y decodificar cuándo se había reproducido un sonido de voz en función de los patrones de actividad neuronal de la corteza auditiva.

Los investigadores encontraron que la mayor parte de esa actividad provenía de dos regiones en la corteza auditiva: pliegues de la materia gris del cerebro conocidos como giro temporal superior (STG) y surco temporal superior (STS). Si bien estudios previos de imágenes cerebrales mostraron que STG y STS son importantes para el procesamiento de la voz, este estudio demuestra que estas regiones representan la voz como una categoría de sonido distinta en lugar de simplemente representar los aspectos físicos o acústicos de la voz.

Este nuevo conocimiento sobre la organización del sistema de reconocimiento de voz conectado a nuestros cerebros permitirá a los investigadores comprender mejor los trastornos neurológicos como la esquizofrenia o el autismo, en los que la percepción de la voz está alterada o falta, e incluso ayudará a crear mejores dispositivos de asistente de voz, que actualmente son bueno para reconocer el habla pero menos hábil para diferenciar entre varios hablantes.

Kyle Rupp, Ph.D., es el autor principal del artículo; los autores adicionales son Jasmine Hect, Madison Remick, Avniel Ghuman, Ph.D. y Bharath Chandrasekaran, Ph.D., todos de Pitt; y Lori Holt, Ph.D., de la Universidad Carnegie Mellon.

Los mecanismos neuronales detrás del autismo: procesamiento sensorial alterado de las señales de comunicación

Las respuestas neuronales en la codificación de soporte de la corteza temporal superior humana de representaciones de voz, PLoS Biología (2022). journals.plos.org/plosbiology/ … journal.pbio.3001675

Citación: Las regiones cerebrales especializadas reconocen señales vocales que no involucran el habla (28 de julio de 2022) recuperado el 28 de julio de 2022 de https://medicalxpress.com/news/2022-07-specialized-brain-regions-vocal-cues.html

Este documento está sujeto a derechos de autor. Aparte de cualquier trato justo con fines de estudio o investigación privados, ninguna parte puede reproducirse sin el permiso por escrito. El contenido se proporciona únicamente con fines informativos.