Crédito: Nitish V. Thakor, Ciencia Medicina Traslacional

Investigadores de la Universidad HSE y la Universidad Estatal de Medicina y Odontología de Moscú han desarrollado un modelo de aprendizaje automático que puede predecir la palabra que va a pronunciar un sujeto, en función de su actividad neuronal registrada con un pequeño conjunto de electrodos mínimamente invasivos. Su artículo, «Decodificación del habla a partir de un pequeño conjunto de electrodos EEG intracraneales mínimamente invasivos separados espacialmente con una red neuronal compacta e interpretable», ha sido publicado en la revista Revista de Ingeniería Neural.

Millones de personas en todo el mundo se ven afectadas por trastornos del habla, lo que limita su capacidad para comunicarse. Las causas de la pérdida del habla pueden variar e incluir un derrame cerebral y ciertas condiciones congénitas.

La tecnología está disponible hoy para restaurar la función de comunicación de dichos pacientes, incluidas las interfaces de «habla silenciosa» que reconocen el habla al rastrear el movimiento de los músculos articulatorios a medida que la persona pronuncia palabras sin emitir un sonido. Sin embargo, estos dispositivos ayudan a algunos pacientes pero no a otros, como las personas con parálisis de los músculos faciales.

Las neuroprótesis del habla (interfaces cerebro-computadora capaces de decodificar el habla en función de la actividad cerebral) pueden proporcionar una solución accesible y confiable para restaurar la comunicación con dichos pacientes.

A diferencia de las computadoras personales, los dispositivos con una interfaz cerebro-computadora (BCI) son controlados directamente por el cerebro, sin necesidad de un teclado o un micrófono.

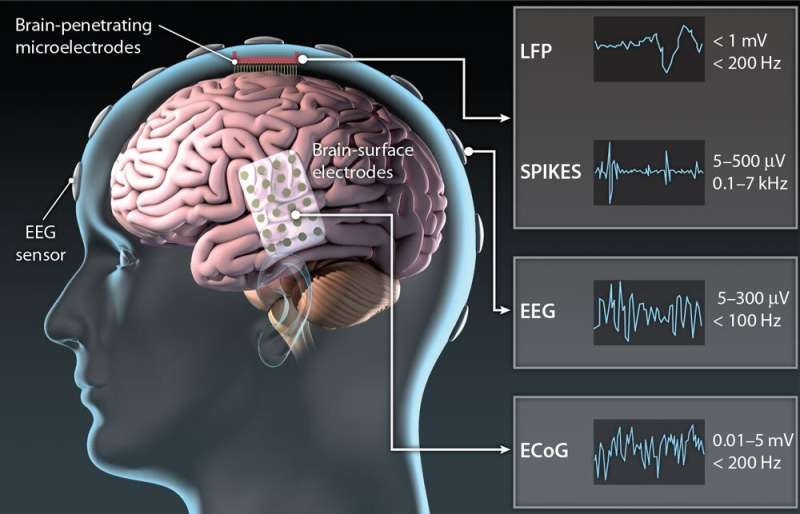

Una barrera importante para un uso más amplio de las BCI en las prótesis del habla es que esta tecnología requiere una cirugía altamente invasiva para implantar electrodos en el tejido cerebral.

El reconocimiento de voz más preciso se logra mediante neuroprótesis con electrodos que cubren una gran área de la superficie cortical. Sin embargo, estas soluciones para leer la actividad cerebral no están destinadas a un uso a largo plazo y presentan riesgos significativos para los pacientes.

Investigadores del Centro HSE para Interfaces Bioeléctricas y la Universidad Estatal de Medicina y Odontología de Moscú han estudiado la posibilidad de crear una neuroprótesis funcional capaz de decodificar el habla con una precisión aceptable mediante la lectura de la actividad cerebral de un pequeño conjunto de electrodos implantados en un área cortical limitada. Los autores sugieren que, en el futuro, este procedimiento mínimamente invasivo podría incluso realizarse con anestesia local.

En el presente estudio, los investigadores recopilaron datos de dos pacientes con epilepsia a los que ya se les habían implantado electrodos intracraneales con el fin de realizar un mapeo prequirúrgico para localizar las zonas de inicio de las convulsiones.

Al primer paciente se le implantó bilateralmente un total de cinco ejes sEEG con seis contactos en cada uno, y al segundo paciente se le implantaron nueve tiras electrocorticográficas (ECoG) con ocho contactos cada una. A diferencia de ECoG, los electrodos para sEEG se pueden implantar sin una craneotomía completa a través de un orificio perforado en el cráneo. En este estudio, solo se usaron los seis contactos de un solo eje sEEG en un paciente y los ocho contactos de una tira ECoG en el otro para decodificar la actividad neuronal.

Se pidió a los sujetos que leyeran en voz alta seis oraciones, cada una presentada de 30 a 60 veces en un orden aleatorio. Las oraciones variaban en estructura y la mayoría de las palabras dentro de una sola oración comenzaban con la misma letra. Las oraciones contenían un total de 26 palabras diferentes. Mientras los sujetos leían, los electrodos registraban su actividad cerebral.

Luego, estos datos se alinearon con las señales de audio para formar 27 clases, incluidas 26 palabras y una clase de silencio. El conjunto de datos de entrenamiento resultante (que contiene señales registradas en los primeros 40 minutos del experimento) se introdujo en un modelo de aprendizaje automático con una arquitectura basada en redes neuronales. La tarea de aprendizaje de la red neuronal era predecir la siguiente palabra pronunciada (clase) en función de los datos de actividad neuronal que preceden a su pronunciación.

Al diseñar la arquitectura de la red neuronal, los investigadores querían que fuera simple, compacta y fácilmente interpretable. Idearon una arquitectura de dos etapas que primero extrajo representaciones internas del habla de los datos de actividad cerebral registrados, produciendo coeficientes espectrales log-mel, y luego predijo una clase específica, es decir, una palabra o un silencio.

Así entrenada, la red neuronal logró un 55 % de precisión usando solo seis canales de datos registrados por un solo electrodo sEEG en el primer paciente y un 70 % de precisión usando solo ocho canales de datos registrados por una sola tira ECoG en el segundo paciente. Tal precisión es comparable a la demostrada en otros estudios que utilizaron dispositivos que requerían que se implantaran electrodos sobre toda la superficie cortical.

El modelo interpretable resultante permite explicar en términos neurofisiológicos qué información neuronal contribuye más a predecir una palabra a punto de ser pronunciada. Los investigadores examinaron las señales provenientes de diferentes poblaciones neuronales para determinar cuáles de ellas eran fundamentales para la tarea posterior. Sus hallazgos fueron consistentes con los resultados del mapeo del habla, lo que sugiere que el modelo usa señales neuronales que son fundamentales y, por lo tanto, pueden usarse para decodificar el habla imaginaria.

Otra ventaja de esta solución es que no requiere ingeniería de características manual. El modelo ha aprendido a extraer representaciones del habla directamente de los datos de actividad cerebral. La interpretabilidad de los resultados también indica que la red decodifica señales del cerebro en lugar de cualquier actividad concomitante, como señales eléctricas de los músculos articulatorios o que surgen debido a un efecto de micrófono.

Los investigadores enfatizan que la predicción siempre se basó en los datos de actividad neuronal que preceden al enunciado. Esto, argumentan, asegura que la regla de decisión no utilizó la respuesta de la corteza auditiva al habla ya pronunciada.

«El uso de tales interfaces implica riesgos mínimos para el paciente. Si todo sale bien, podría ser posible decodificar el habla imaginaria a partir de la actividad neuronal registrada por una pequeña cantidad de electrodos mínimamente invasivos implantados en un entorno ambulatorio con anestesia local», dice Alexey. Ossadtchi, autor principal del estudio, director del Centro de Interfaces Bioeléctricas del Instituto HSE de Neurociencia Cognitiva.

Más información:

Artur Petrosyan et al, Decodificación del habla a partir de un pequeño conjunto de electrodos EEG intracraneales mínimamente invasivos segregados espacialmente con una red neuronal compacta e interpretable, Revista de Ingeniería Neural (2022). DOI: 10.1088/1741-2552/aca1e1

Proporcionado por la Escuela Superior de Economía de la Universidad Nacional de Investigación

Citación: La prótesis neural usa la actividad cerebral para decodificar el habla (2023, 19 de enero) recuperado el 19 de enero de 2023 de https://medicalxpress.com/news/2023-01-neural-prosthesis-brain-decode-speech.html

Este documento está sujeto a derechos de autor. Aparte de cualquier trato justo con fines de estudio o investigación privados, ninguna parte puede reproducirse sin el permiso por escrito. El contenido se proporciona únicamente con fines informativos.