SINGAPUR: Los padres y los jóvenes dijeron el jueves (21 de julio) que las plataformas de redes sociales podrían responder mejor a las necesidades de Singapur, en medio de las crecientes preocupaciones sobre la seguridad en línea.

Durante una consulta pública sobre seguridad en línea el jueves por la noche, varios participantes destacaron que algunos servicios ofrecidos por las plataformas de redes sociales podrían diseñarse mejor para ayudar a más usuarios a informar contenido dañino o brindar comentarios.

Una participante compartió que cuando trató de denunciar un contenido dañino en una plataforma de redes sociales, enfrentó dificultades porque no se encontraba dentro de ninguna de las categorías provistas en la herramienta de denuncia.

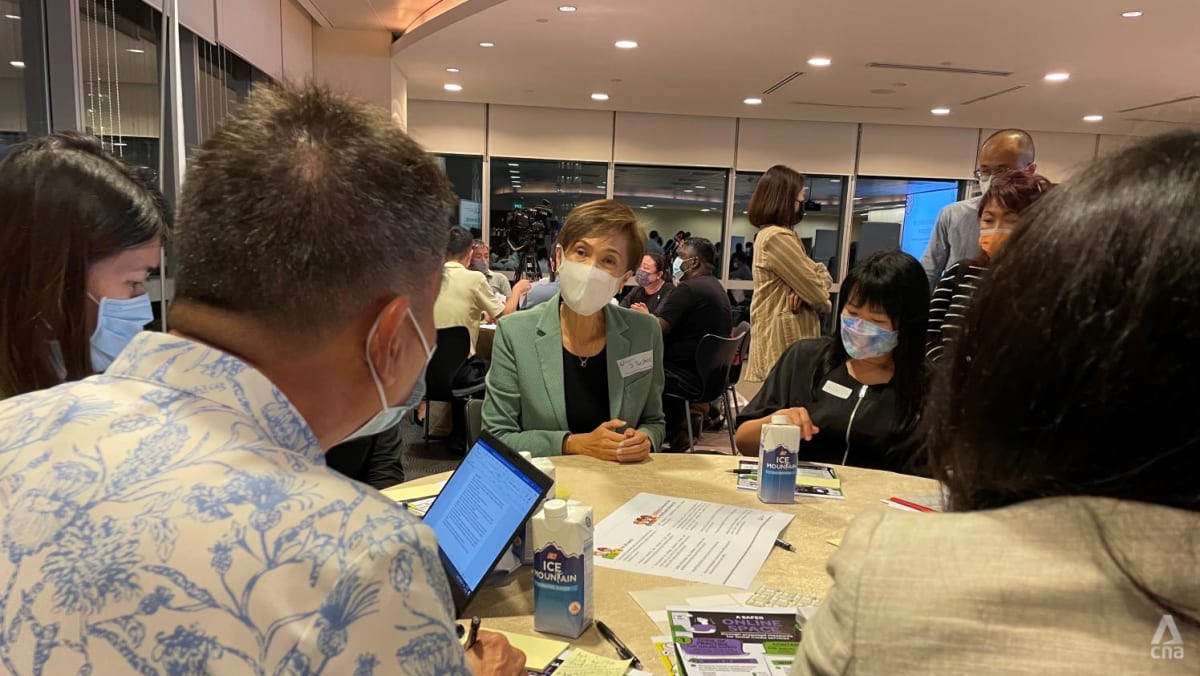

En declaraciones a los periodistas al margen de la discusión del grupo focal con padres y jóvenes el jueves, la ministra de Comunicaciones e Información, Josephine Teo, también señaló que la conciencia de las herramientas de seguridad del usuario era desigual entre los participantes.

“Eso resalta la necesidad de una mayor conciencia sobre estas herramientas de seguridad para que estén disponibles para los usuarios”, dijo.

“Incluso entre quienes conocen estas herramientas, existe un mayor deseo de que los servicios de redes sociales respondan mejor a sus necesidades individuales de información, así como a las condiciones de la comunidad”, agregó.

Esta es la tercera discusión de grupo focal que se lleva a cabo hasta ahora, como parte de una consulta pública de un mes que se lanzó el 13 de julio. Unas 60 personas asistieron a la discusión el jueves.

La consulta tiene como objetivo obtener comentarios sobre dos conjuntos de propuestas anunciadas por el Ministerio de Comunicaciones e Información en junio.

La primera propuesta es que los servicios de redes sociales designados con un alcance o impacto significativo tengan procesos en todo el sistema para mejorar la seguridad en línea para todos los usuarios, con garantías adicionales para los usuarios jóvenes menores de 18 años.

Esto incluye tener estándares comunitarios y mecanismos de moderación de contenido para mitigar la exposición de los usuarios a cierto contenido dañino, y detectar y eliminar proactivamente material de explotación y abuso sexual infantil, así como contenido de terrorismo.

La segunda es que la Autoridad de Desarrollo de Medios de Infocomm (IMDA) puede ordenar a cualquier servicio de redes sociales que elimine tipos específicos de «contenido atroz». Estos incluyen la seguridad en relación con el daño sexual, la autolesión o la salud pública. Las áreas de preocupación también incluyen la seguridad pública y la falta de armonía o intolerancia racial o religiosa.