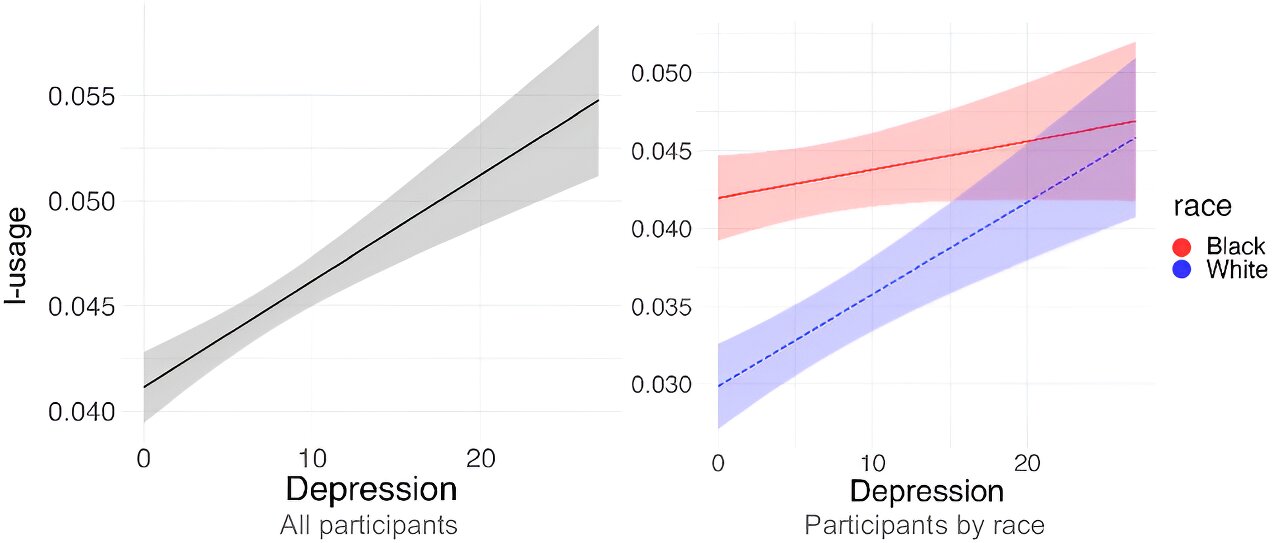

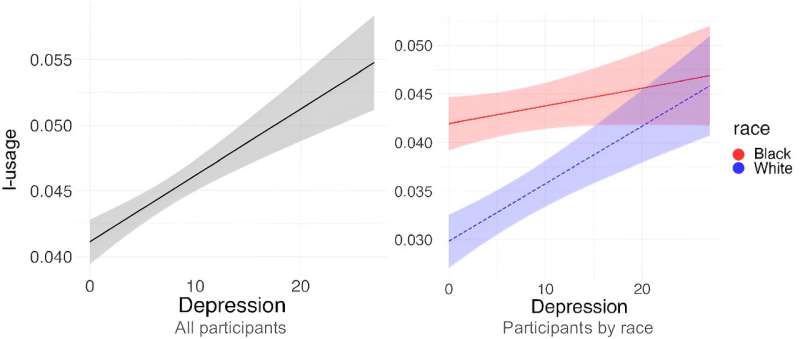

Izquierda: uso de I en función de la gravedad de la depresión (medida mediante PHQ-9). El uso de I crece linealmente con la depresión. Derecha: uso de I por carrera del participante después de la interacción. Para los participantes blancos, niveles más altos de depresión condujeron a un mayor uso de I, mientras que los participantes negros exhibieron niveles de uso de I que no variaron en función de la gravedad de la depresión.

Los investigadores pudieron predecir la gravedad de la depresión en los blancos, pero no en los negros, utilizando modelos informáticos basados en lenguaje estándar para analizar las publicaciones de Facebook. Las palabras y frases asociadas con la depresión, como los pronombres en primera persona y las palabras de emociones negativas, predecían aproximadamente tres veces más la gravedad de la depresión en los blancos que en los negros.

El estudio, publicado hoy en el procedimientos de la Academia Nacional de Cienciastiene como coautoría investigadores de la Universidad de Pensilvania, Filadelfia, y el Instituto Nacional sobre el Abuso de Drogas (NIDA), parte de los Institutos Nacionales de Salud (NIH).

Si bien investigaciones anteriores han indicado que el lenguaje de las redes sociales podría proporcionar información útil como parte de las evaluaciones de salud mental, los hallazgos de este estudio apuntan a posibles limitaciones a la hora de generalizar esta práctica al resaltar diferencias demográficas clave en el lenguaje utilizado por las personas con depresión. Los resultados también resaltan la importancia de incluir diversos conjuntos de datos para garantizar la precisión a medida que se desarrollan modelos de aprendizaje automático, una aplicación de modelos de lenguaje de inteligencia artificial (IA).

«A medida que la sociedad explora el uso de la IA y otras tecnologías para ayudar a brindar la tan necesaria atención de salud mental, debemos asegurarnos de que nadie se quede atrás o sea tergiversado», dijo Nora Volkow, MD, directora del NIDA. «Es esencial contar con conjuntos de datos más diversos para garantizar que la IA no perpetúe las disparidades en la atención médica y que estas nuevas tecnologías puedan ayudar a adaptar intervenciones de atención médica más efectivas».

El estudio, que reclutó a 868 participantes que dieron su consentimiento y se identificaron como blancos o negros, demostró que los modelos entrenados en el lenguaje de Facebook utilizado por participantes blancos con depresión autoinformada mostraron un fuerte rendimiento predictivo cuando se probaron en los participantes blancos. Sin embargo, cuando los mismos modelos fueron entrenados en el lenguaje de Facebook por parte de participantes negros, tuvieron un desempeño deficiente cuando se probaron con participantes negros y mostraron un rendimiento solo ligeramente mejor cuando se probaron con participantes blancos.

Si bien la gravedad de la depresión se asoció con un mayor uso de pronombres de primera persona del singular («yo», «mí», «mi») en los participantes blancos, esta correlación estuvo ausente en los participantes negros. Además, los blancos usaban más lenguaje para describir sentimientos de pertenencia («bicho raro», «horripilante»), autocrítica («desorden», «desastre»), ser un extraño ansioso («aterrorizado», «incomprendido»), autodesprecio («inútil», «basura») y desesperación («mendicidad», «vacío») a medida que aumentaba la gravedad de la depresión, pero no hubo tal correlación para los negros. Durante décadas, los médicos han sido conscientes de las diferencias demográficas en la forma en que las personas expresan los síntomas depresivos, y este estudio ahora demuestra cómo esto puede afectar las redes sociales.

Los modelos basados en el lenguaje son prometedores como herramientas personalizadas, escalables y asequibles para detectar trastornos de salud mental. Por ejemplo, el lenguaje autorreferencial excesivo, como el uso de pronombres en primera persona, y las emociones negativas, como el lenguaje autocrítico, a menudo se consideran indicadores clínicos de depresión.

Sin embargo, ha habido una notable ausencia de consideraciones raciales y étnicas en la evaluación de los trastornos mentales a través del lenguaje, una exclusión que conduce a modelos informáticos inexactos. A pesar de la evidencia que muestra que los factores demográficos influyen en el lenguaje que usan las personas, estudios anteriores no han explorado sistemáticamente cómo la raza y el origen étnico influyen en la relación entre la depresión y la expresión del lenguaje.

Los investigadores establecieron este estudio para ayudar a cerrar esta brecha. Analizaron publicaciones anteriores en Facebook de personas blancas y negras que autoinformaron la gravedad de la depresión a través del Cuestionario de salud del paciente (PHQ-9), una herramienta de autoinforme estándar utilizada por los médicos para detectar una posible depresión. Los participantes dieron su consentimiento para compartir sus actualizaciones de estado de Facebook. Los participantes eran principalmente mujeres (76%) y tenían entre 18 y 72 años. Los investigadores compararon a los participantes blancos y negros por edad y sexo para que los datos de los dos grupos fueran comparables.

Los hallazgos del estudio desafían las suposiciones sobre el vínculo entre el uso de ciertas palabras y la depresión, particularmente entre los participantes negros. Los investigadores señalan que las prácticas clínicas actuales en salud mental que no han tenido en cuenta los matices raciales y étnicos pueden ser menos relevantes, o incluso irrelevantes, para las poblaciones históricamente excluidas de la investigación en salud mental. También plantean la hipótesis de que la depresión puede no manifestarse en el lenguaje de la misma manera en algunas personas negras; por ejemplo, el tono o la velocidad del habla, en lugar de la selección de palabras, pueden relacionarse más con la depresión en esta población.

«Nuestra investigación representa un paso adelante en la construcción de modelos lingüísticos más inclusivos. Debemos asegurarnos de que los modelos de IA incorporen la voz de todos para que la tecnología sea justa para todos», afirmó Brenda Curtis, Ph.D., MsPH, jefa de Tecnología e Investigación Traslacional. Unidad de Medicina Traslacional de Adicciones del Programa de Investigación Intramuros del NIDA y uno de los autores principales del estudio. «Prestar atención a los matices raciales en cómo se expresa la salud mental permite a los profesionales médicos comprender mejor cuándo un individuo necesita ayuda y brindar intervenciones más personalizadas».

Los autores dicen que los estudios futuros deberán examinar las diferencias entre otras razas y características demográficas, utilizando varias plataformas de redes sociales. También advierten que el lenguaje de las redes sociales no es análogo al lenguaje cotidiano, por lo que el trabajo futuro sobre modelos basados en el lenguaje debe tener esto en cuenta.

«Es importante tener en cuenta que el lenguaje de las redes sociales y los modelos de inteligencia artificial basados en el lenguaje no son capaces de diagnosticar trastornos de salud mental (ni reemplazan a los psicólogos o terapeutas), pero sí muestran una inmensa promesa para ayudar en la detección e informar intervenciones personalizadas», dijo. El autor principal del estudio, Sunny Rai, Ph.D., investigador postdoctoral en Ciencias de la Información y la Computación en la Universidad de Pensilvania. «Se necesitan muchas mejoras antes de que podamos integrar la IA en la investigación o la práctica clínica, y el uso de datos diversos y representativos es uno de los más críticos».

Más información:

Sunny Rai et al, Los marcadores lingüísticos clave de la depresión en las redes sociales dependen de la raza, procedimientos de la Academia Nacional de Ciencias (2024). DOI: 10.1073/pnas.2319837121

Citación: El análisis de IA del lenguaje de las redes sociales predice la gravedad de la depresión en los estadounidenses blancos, pero no en los estadounidenses negros (2024, 26 de marzo) recuperado el 26 de marzo de 2024 de https://medicalxpress.com/news/2024-03-ai-analysis-social-media -idioma.html

Este documento está sujeto a derechos de autor. Aparte de cualquier trato justo con fines de estudio o investigación privados, ninguna parte puede reproducirse sin el permiso por escrito. El contenido se proporciona únicamente con fines informativos.